Cours à option à l'université de sherbrooke : GRO860 . La version automne 2024 sera les lundi 13h-16h en salle à déterminer.

Le but du cours est de faire le lien entre le domaine des asservissements et les algorithmes de décision basé sur l’IA. Le cours présentera les outils pour vous permettre de de traduire un problème de décisions en temps réel sous la représentation mathématique adapté pour synthétiser et optimiser une politique de décision, avec des applications dans plusieurs domaines de la robotique à la finance.

Ce cours présente les approches pour prendre des décisions intelligentes sous un cadre théorique unifié basé sur le principe de la programmation dynamique. Il vise d'abord a établir les liens entre les approches issues du domaine de l'ingénierie (la science des asservissements et la commande optimale) et les approches issues des sciences informatiques (recherche opérationnelle et l'apprentissage par renforcement) qui ont en fait les même bases mathématiques. Il vise principalement à donner à un lecteur issue du domaine de l'ingénierie les bases pour comprendre et utiliser les approches numériques issues des sciences informatiques, comme l'apprentissage par renforcement, qui permettent de calculer des politiques décisionnelles optimales.

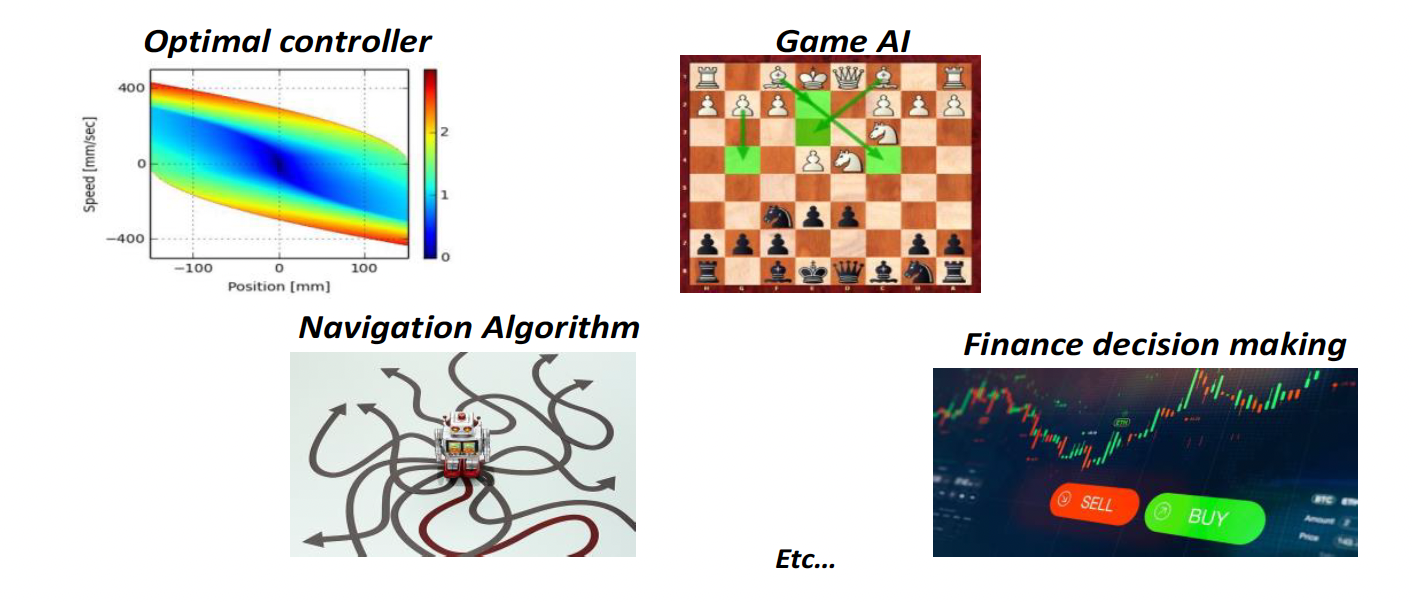

Plusieurs problèmes en apparence très différents, sont en fait des problèmes qu'on peut analyser et résoudre avec les mêmes outils mathématiques

| Semaines | Sujets | Travaux |

|---|---|---|

| 1 |

Introduction

|

|

| 2 à 8 |

Principe d’optimalité

|

Devoirs papier/crayon + devoirs de code (Python) |

| 2 à 8 |

Modélisation

|

Devoirs papier/crayon + devoirs de code (Python) |

| 2 à 8 |

Méthode de synthèse / apprentissage

|

Devoirs papier/crayon + devoirs de code (Python) |

| 8 à 12 |

Méthodes avancées

|

Projet de session

|